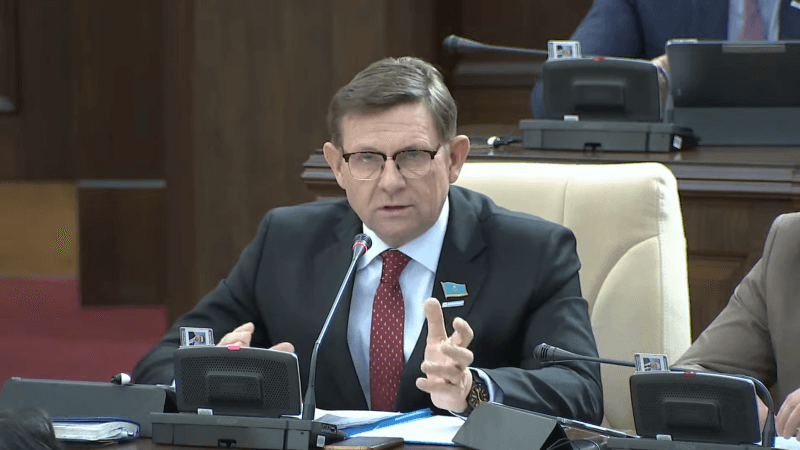

У прогресса есть и обратная сторона. По мнению мажилисмена Сергея Пономарева, это технологии, которые могут использоваться не во благо, а во вред. Одна из них — технология дипфейков, то есть создание при помощи искусственного интеллекта поддельных изображений, аудио- и видеоматериалов с участием реальных людей. И депутат лично, как он заявил в своем депутатском запросе на имя министра искусственного интеллекта и цифрового развития РК Жаслана Мадиева, а также министра МВД РК Ержана Саденова, «стал жертвой такой технологии»

Вместе с тем мажилисмен отмечает, что «цифровизация и технологический прогресс сегодня не просто направление, а новая национальная идея Казахстана». Однако, согласно данным Всемирного экономического форума, уже второй год подряд дезинформацию и распространение ложных сведений называют среди главных краткосрочных рисков для мировой стабильности.

— Я лично стал жертвой такой технологии, мое изображение и голос были полностью подделаны, использованы в ролике, где от моего имени просили деньги. Смонтировано настолько искусно, что даже близкие не сразу поняли подделку. Уверен, с подобным сталкивались многие. Мы уже видели дипфейки с участием зарубежных политиков и даже с использованием образа Президента Казахстана, — возмутился Сергей Пономарев.

Он также отмечает, что качество подделок растет, и с ним растут риски манипуляции общественным мнением, дискредитации государственных органов и дестабилизации общественно-политической ситуации.

— Если будет создан и распространен дипфейк с участием руководителя государства или публичного лица с ложными призывами или фальшивыми заявлениями, последствия могут быть катастрофическими. Это уже угроза национальной безопасности, — подчеркнул депутат.

Мировая практика также подтверждает серьезность проблемы. Например, США еще в 2020 году включили положения о дипфейках в Закон «Об оборонном бюджете», определив их как фактор информационной безопасности. Корея перед парламентскими выборами 2024 года ввела запрет на использование дипфейков в агитации за 90 дней до голосования, нарушение которого могло повлечь штраф или лишение свободы. В ряде стран внедряются технологии автоматического выявления подделок, а также механизмы цифровой маркировки оригинального контента.

Однако дипфейки все чаще используются в финансовом мошенничестве. Ведь когда человек слышит голос близкого с просьбой о помощи или наблюдает его по видео, «на эту удочку попадаются даже высокообразованные граждане». Более того, как сообщила в своем отчете компания Feedzai за 2025 год, «свыше 50 процентов случаев онлайн-мошенничества совершается с использованием искусственного интеллекта».

Да, в ответ банки и платежные системы уже переходят к использованию ИИ-решений для защиты клиентов. Но главная проблема, полагает депутат, при этом остается — это ущерб репутации.

— Даже если позднее размещается опровержение, вред уже нанесен, и восстановить доверие практически невозможно. С учетом стремительного роста социальной инженерии и распространения технологий искусственного интеллекта требую от Министерства искусственного интеллекта и Министерства внутренних дел действовать на опережение и принять комплекс мер, — заключил Сергей Пономарев.

В числе предлагаемых мер, во-первых, вменить в обязанности Центра мониторинга и экспертизы цифрового контента обеспечение и оперативное выявление дипфейков и их блокировку. Во-вторых, разработать систему подтверждения подлинности цифровых изображений и видеоматериалов, особенно в государственных информационных системах и официальных медиа. И этот инструмент должен быть доступен не только судам, но и каждому гражданину, который захочет проверить изображение на подлинность. И, наконец, провести широкую информационную кампанию по обучению граждан методам распознавания дипфейков и защите от цифрового мошенничества.

Получится ли?